Самый слабый процессор в мире на пк

Обновлено: 06.07.2024

Обладатели персональных компьютеров со стажем любят вспоминать процессоры, которые внесли значительный вклад в их развитие. Между тем, даже у ведущих производителей не всегда всё происходит гладко, и иногда продукты получаются неудачными. Настолько, что удивляешься, как их вообще решили выпустить.

реклама

Мы рассмотрим процессоры, у которых были какие-то фундаментальные изъяны, а не просто производительность ниже ожидаемой. История хранит память о множестве посредственных продуктов, которые не оправдали ожиданий, но мы выберем самые худшие из них.

Многие бы включили сюда ошибку Pentium FDIV, но мы не станем этого делать. Это была крупная маркетинговая ошибка Intel, которая обошлось в копеечку. Сам по себе баг был не настолько значительный. Если вы не занимались какими-либо научными вычислениями, вас он никак не касался. Этот инцидент сейчас можно вспоминать только потому, что Intel неудачно справилась с ним, а не в качестве проблемы процессорной архитектуры.

Intel Itanium

Это была радикальная попытка объединить аппаратную сложность и программные оптимизации. Всю работу по определению того, какую команду выполнять параллельно, делал компилятор до того, как процессор выполнял хотя бы байт кода. Аналитики предсказывали, что Itanium завоюет мир. Этого не случилось. Компиляторы не смогли предложить необходимую производительность, и процессор был абсолютно несовместим со всем тем, что было выпущено до него. Казалось, что он полностью заменит собой архитектуру x86, но в итоге процессор несколько лет влачил жалкое существование и был нишевым продуктом.

Intel Pentium 4 Prescott

реклама

var firedYa28 = false; window.addEventListener('load', () => < if(navigator.userAgent.indexOf("Chrome-Lighthouse") < window.yaContextCb.push(()=>< Ya.Context.AdvManager.render(< renderTo: 'yandex_rtb_R-A-630193-28', blockId: 'R-A-630193-28' >) >) >, 3000); > > >);

Prescott удвоил и без того длинный конвейер Pentium 4, расширив его до более чем 30 стадий, с одновременным переходом на техпроцесс 90 нм. Это было ошибкой. Скорость упала настолько, что даже новый блок предсказания ветвлений не помог, а утечки тока привели к повышенному энергопотреблению. Это не позволило добиться тактовой частоты, при которой процессор был бы успешным. Prescott и его 2-ядерный родственник Smithfield оказались наиболее слабыми продуктами для настольных ПК по сравнению с конкурентами того времени.

AMD Bulldozer

Этот процессор должен был отнять у Intel долю рынка за счёт повышения эффективности и сокращения площади чипа. AMD хотела предложить более компактное ядро с более высокими частотами, что позволило бы компенсировать недостатки общих ресурсов. В итоге получилась катастрофа. Необходимые тактовые частоты не были достигнуты, расход энергии был слишком большой, а производительность ниже требуемой. В итоге о конкуренции с Intel AMD не могла и мечтать.

Cyrix 6x86

реклама

Cyrix был одним из производителей процессоров на архитектуре x86, который не пережил 90-е годы. Процессоры вроде этого были одной из причин схода компании со сцены. 6x86 заметно опережал Intel Pentium в операциях с целыми числами, но его блок операций с плавающей запятой был ужасен, и стабильность при работе с материнскими платами с Socket 7 оставляла желать много лучшего. Если в конце 1990-х вы играли в компьютерные игры, лучшим выбором были процессоры Intel, можно было довольствоваться AMD, а 6x86 относился к малоприятной категории «Прочее». Он вряд ли кого-то порадовал бы даже в качестве подарка.

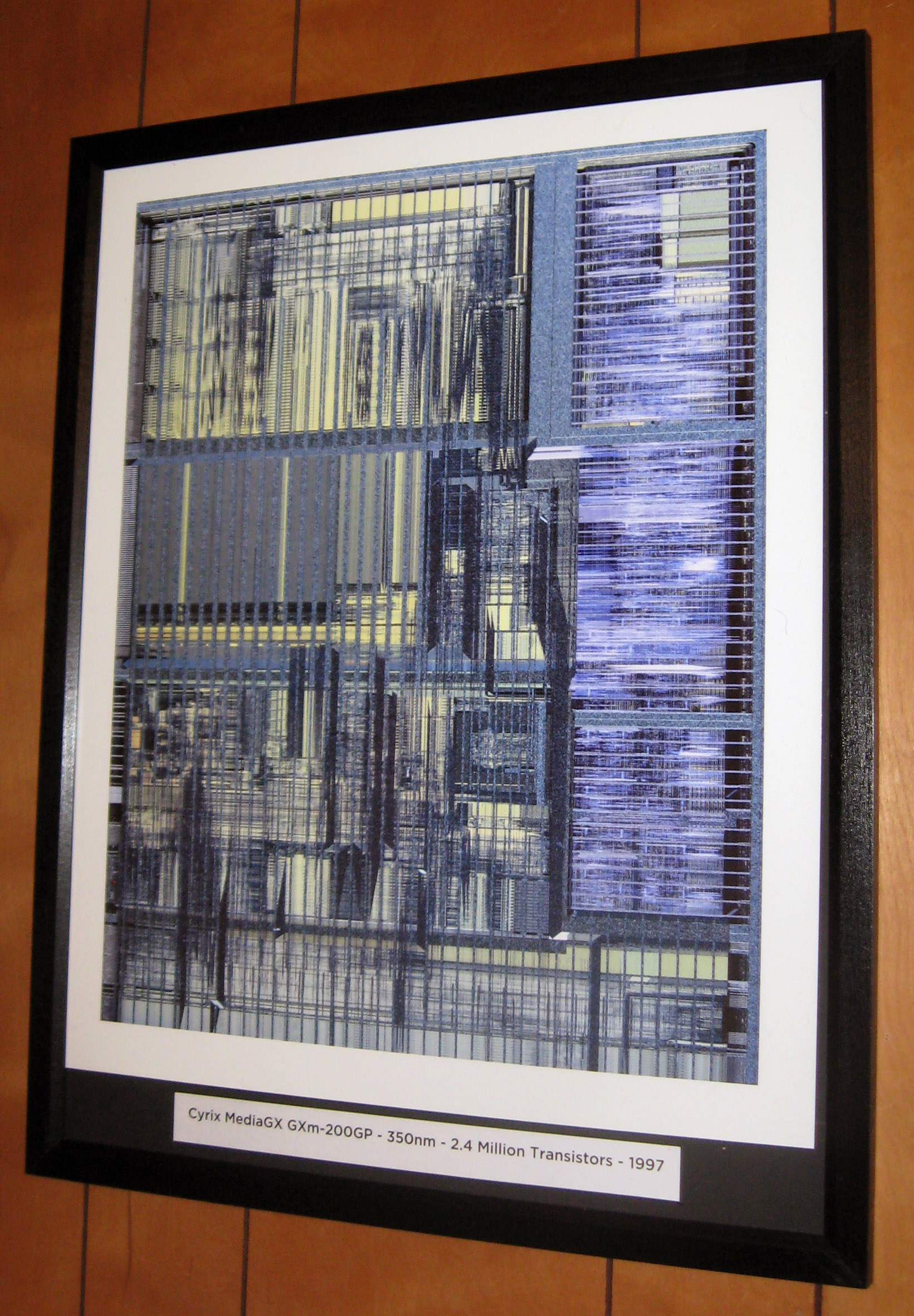

Cyrix MediaGX

MediaGX был первой попыткой создать систему на чипе для персональных компьютеров с графикой, центральным процессором, шиной PCI и контроллером памяти на одном кристалле. К сожалению, 1998 год был неподходящим временем для этого. Все эти компоненты вышли весьма неудачными. Совместимость с материнской платой была ограниченной. Архитектура центрального процессора Cyrix 5x86 была эквивалентна Intel 80486, он не мог подключиться к кэшу второго уровня, который находился за пределами чипа (других тогда не было). Cyrix 6x86 хотя бы мог противостоять процессорам Intel в бизнес приложениях, MediaGX не был способен даже на это.

Texas Instruments TMS9900

реклама

Когда IBM искала процессор для оригинального IBM PC, выбор стоял между этим чипом и Intel 8086/8088, в разработке ещё находился Motorola 68K. TMS9900 имел 16 бит адресного пространства, тогда как 8086 предлагал 20 бит. В результате в одном случае объём оперативной памяти мог быть только 64 килобайт, в другом 1 Мб. Отсутствовали регистры общего назначения. 16 16-битных регистров хранились в главной памяти. Естественно, IBM отдала предпочтение Intel.

Непочётные упоминания: Qualcomm Snapdragon 810

Snapdragon 810 был первой попыткой Qualcomm построить процессор на архитектуре big.Little на техпроцессе TSMC 20 нм, который просуществовал недолго. За последние годы это был самый непопулярный чип Qualcomm. Samsung полностью пропустила его в своих смартфонах, другие компании столкнулись с серьёзными проблемами при работе с ним. Разработчики процессора заявляли, что виновато плохое управление электропитанием со стороны производителей мобильных устройств. В любом случае, процессор перегревался и расходовал слишком много энергии.

IBM PowerPC G5

Партнёрство IBM и Apple при работе над PowerPC 970, который Apple называла G5, должно было стать судьбоносным. Когда были анонсированы первые устройства на G5, Apple обещала выпустить процессор с частотой 3 ГГц в течение года. IBM не смогла обеспечить нужные компоненты, которые могли бы достичь подобных частот при умеренном энергопотреблении. G5 не смог как следует заменить G4 в ноутбуках из-за высокого расхода энергии. Apple была вынуждена перейти на Intel и архитектуру x86, чтобы продолжать выпускать конкурентоспособные ноутбуки.

Pentium 3 1,13 ГГц

Сама по себе архитектура Pentium 3 было отличной. Вот только во время гонки тактовых частот против AMD Intel всеми силами старалась сохранить лидерство по производительности, поскольку поставки дорогостоящих систем снижались. В одно время оценки показали, что AMD имеет преимущество 12:1 по продажам процессоров 1 ГГц. Intel предприняла отчаянную попытку повысить частоту Pentium 3 на техпроцессе 180 нм до 1,13 ГГц. Она провалилась. Процессор работал крайне нестабильно, и Intel отозвала всю партию.

Cell Broadband Engine

Отличный пример того, как процессор может быть феноменальным теоретически, но как его почти невозможно реализовать на практике. Sony использовала его как процессор общего назначения в PlayStation 3, но он был намного лучше при обработке мультимедиа и векторных вычислениях, чем в приложениях общего назначения. Его разработка относится к тем временам, когда Sony собиралась обрабатывать команды центрального и графического процессора единой архитектурой. Было крайне непросто разделить команды на потоки, чтобы воспользоваться его Synergistic Processing Elements, а отличия от других архитектур были слишком большими.

Продолжаем подборку не самых лучших процессоров, при выходе которых на рынок возникал лишь один вопрос — а смысл было их выпускать-то?

Intel Core i7-2700K (2011)

Ни для кого не секрет, что второе поколение процессоров Intel Core i было крайне хорошим — тут и припой под крышкой, позволяющий разогнать CPU до 4.5+ ГГц, и поддержка AVX инструкций, что здорово помогает в расчетных задачах — в общем, эти процессоры достаточное количество пользователей эксплуатируют до сих пор, ибо старшие решения в линейке без проблем работают вместе с GTX 1060 и даже 1070.

Однако самый старший представитель второго поколения — i7-2700K — вызывал некоторое удивление. Посудите сами — его от крайне популярного i7-2600K отличает лишь 100 МГц частоты и несколько десятков долларов стоимости, причем они оба разгоняются и имеют полностью идентичные кристаллы, что позволяют достичь одинаковых частот. Поэтому продажи i7-2700K были крайне низкими, и Intel поняли свою ошибку — начиная с третьего поколения в каждой линейке (Core i3, i5 и i7) был только один процессор с возможностью разгона.

Pentium D (2005)

Чтобы поспеть за AMD, которые выпускали первые двухядерные процессоры Athlon 64 X2, Intel в спешке взяла два кристалла от Pentium 4, поместила их на одну подложку и стала продавать как двухядерный процессор. Разумеется, возникло просто море проблем: во-первых, Pentium 4 были сами по себе достаточно горячими, а два их вместе требовали очень хорошего теплоотвода, ибо тепловыделение достигало 130 Вт. Во-вторых, в то время пользовательский софт не умел работать с двумя ядрами, нагружая только одно, а с учетом того, что в Pentium D Intel снизила частоту процессора, чтобы он меньше грелся, то старшие Pentium 4 зачастую оказывались быстрее. В-третьих, для этих процессоров требовалось покупать новую материнскую плату из-за более высоких требований к VRM (питанию процессора), и на старте эти платы имели только поддержку памяти DDR2, которая была тогда достаточно новой, дорогой и зачастую более медленной, чем DDR.

Итог был немного предсказуем — с учетом того, что Athlon 64 X2 этих недостатков был лишен, его продажи были куда выше, даже с учетом более высокой цены. Intel же выпускала свои «топорные» двухядерные Pentium D вплоть до 2008 года, причем с минимальными обновлениями.

AMD FX-9590 (2013)

К концу 2013 года стало понятно, что архитектура Vishera от AMD свое отжила. Однако, как мы помним, Ryzen вышли только в 2017 году, так что компании нужно было как-то продавать свои десктопные решения. И выход был найден — путем «грубой силы» был сделан FX-9590 — первый десктопный процессор, способный «из коробки» работать на частоте в 5 ГГц. Почему путем «грубой силы»? Да потому что AMD банально сильно повысила напряжение, чтобы процессор мог работать на такой частоте. Конечно, тут еще был отбор наиболее удачных для разгона кристаллов, но все еще в основном такие частоты «брались» благодаря повышению напряжения на

0.1 В в сравнении со «стандартными» FX-8320 и 8350.

В итоге такое повышение напряжения привело к тому, что процессор имел теплопакет в 220 Вт — доселе невиданная цифра даже среди высокопроизводительных решений, где максимум колебался в районе 150 Вт. С учетом того, что максимальная допустимая температура у Vishera всего 75 градусов против 100 у Intel, для охлаждения такого монстра приходилось использовать или систему водяного охлаждения, или большой башенный кулер. К тому же далеко не каждая материнская плата имела цепи питания, способные отдать свыше 200 Вт — AMD даже подготовила список таких плат, которых было всего 8 (и это при том, что всего плат под Vishera было под сотню).

С учетом того, что тот же i7-4770K стоил всего на 10 долларов дороже, но при этом имел теплопакет в 2.5 раза ниже, работал на любой плате под LGA1150 и, что самое главное, зачастую был до полутора-двух раз быстрее — очевидно, что продажи FX-9590 были крайне низкими, а сам этот процессор стал последним гвоздем в крышке гроба с Vishera.

Во времена «войн» между AMD и Intel многие забыли про такого производителя x86 процессоров, как VIA, и это не удивительно: если «красные» и «синие» всегда сначала пытались сделать топовые решения, а потом, путем их урезания, получались более слабые, то вот VIA никогда в топы не лезла, ограничиваясь дешевым низкопроизводительным сегментом, но бросая на него все силы.

И это принесло свои плоды: в 2008 году, когда вышло в продажу первое поколение процессоров Nano, оказалось — сюрприз — что они лучше и Athlon 64 2000+, и первого поколения Atom. И тут ничего удивительного не было — как я говорил выше, та же AMD получала слабые решения путем урезания мощных, и этот Athlon ничем не отличался от более мощных собратьев, кроме как частотой в. 1 ГГц — да, только так можно было уложиться в теплопакет 10 Вт. Что касается Atom, то он вообще по своим возможностям был ближе к Pentium 4, что в 2008 году смотрелось бледно. VIA же разрабатывала свои процессоры с нуля, с прицелом на низкопроизводительный «холодный» сегмент, поэтому в итоге они и выиграли.

Думаю, у вас уже возник вопрос — а что такие процессоры делают в этой статье, если они были даже лучше конкурентов? Ключевой момент — были. К 2012 году, когда вышло последнее поколение Nano, уже двухядерное, оказалось, что конкуренты тоже на месте не сидели: так, у Intel были готовы уже 4-поточные 1.8 ГГц Atom со встроенным видеоядром, поддерживающим DirectX 10 и возможностью проигрывать 1080р видео. А у AMD были процессоры линейки E (E-350), на которых можно было даже поиграть в современные на тот момент игры — пусть и при минимальных настройках графики. И это при том, что все эти процессоры имели теплопакет ниже 20 Вт. Что же предлагали VIA? Два ядра с частотой в 1.2 ГГц, так что в итоге даже Atom был быстрее. Графику Chrome9 HD прямиком из конца нулевых, с поддержой лишь DirectX 9 и HD-видео. И, что самое худшее — ценник, который был выше, чем у Atom (но, правда, несколько ниже, чем у AMD E-350, но последний был куда мощнее).

В итоге у VIA были все шансы занять низкопроизводительный сегмент, и сейчас выпускались бы планшеты на Windows не с Atom, а с Nano. Но, увы, свой шанс они прошляпили, и в итоге практически ушли с рынка x86-процессоров — почти, потому что в сотрудничестве с китайскими властями VIA недавно представили процессоры KX-6000, построенные по 16 нм техпроцессу, имеющие до 8 ядер с частотой до 3 ГГц. По словам компании, эти решения должны конкурировать с Core i5 6-ого поколения (i5-6400), но как будет на деле — узнаем только через год, когда они выйдут в продажу.

Intel Pentium P5 60/66 МГц (1993)

В первой части статьи я писал о ранних Pentium 4, которые выпускались на мертворожденном сокете 423, который уже спустя год был заменен на 478, процессоры для которого были зачастую до двух раз быстрее. И, оказывается, Intel уже не первый раз так «кидала» пользователей.

Итак, 1993 год. Компания анонсирует процессоры Pentium — суперскалярная архитектура (возможность выполнять 2 команды за 1 такт), 64-битная шина данных, улучшенный математический сопроцессор, механизм предсказания ветвлений — в общем, купить новые процессоры захотели многие. То, что они требовали новые платы с Socket 4, никого не удивляло. И — сюрприз — всего через полгода Intel анонсирует более быстрый Pentium на 75 МГц, требующий уже платы с Socket 5. И через год к ним добавляются процессоры уже на 100 МГц, то есть на 50% быстрее. При этом, разумеется, сокеты 4 и 5 были несовместимыми, так что те, кто купил первые Pentium, остались ни с чем, и им для апгрейда приходилось менять и материнскую плату в том числе.

Intel Celeron Covington (1998)

К концу 90-ых в Intel понимают, что не топами едиными нужно жить — компьютеры становятся все популярнее, и далеко не всем нужны высокопроизводительные устройства — большинству требуются дешевые CPU, способные потянуть систему с офисом и Косынкой. И для удовлетворения спроса Intel в 1998 году выпускает первые Celeron с частотами в 266 и 300 МГц, но без кэша второго уровня L2.

Конечно, для офисных задач этого было более чем достаточно, но после тестов вскрывалась правда — без кэша L2 эти процессоры были даже слабее Pentium MMX годовалой давности с более низкой частотой, которые стоили почти столько же. Из-за этого эти Celeron получили у обзорщиков множество не самых лестных прозвищ — Slugeron (от sluggish — медлительный), Celery (сельдерей) и Deceleron.

С другой стороны, это была просто находка для оверклокеров — так как зачастую именно кэш L2 препятствовал сильному разгону Pentium II (ибо тогда все разгонялось вместе), Celeron без него легко брали 400-450 МГц, из-за чего в играх, для которых кэш L2 был не особо нужен, они оказывались почти на уровне «пеньков», но при этом за куда меньшую цену. Но с учетом того, что разгоном мало кто занимался — доверие к новой линейке было подорвано.

Впрочем, Intel смогла достаточно оперативно решить проблему, и уже через год вышло новое поколение Celeron, уже с кэшем L2, но его было вдвое меньше, чем у текущих Pentium: да, это снижало их производительность, но не настолько, чтобы они были хуже предыдущих поколения Pentium, так что линейка Celeron на долгие годы стала популярным решением для сборки не самых дорогих ПК.

На этом на сегодня все, и, если я найду еще материал, выйдет третья и скорее всего заключительная статья по худшим процессорам в истории ПК.

За всю полувековую историю компьютеров различные компании выпустили несколько сотен процессоров. Разумеется, среди них были отличные для своего времени решения, были просто хорошие, и конечно же были CPU, при изучении которых возникал вопрос — зачем ЭТО вообще было выпускать? И именно о таких процессорах мы сегодня и поговорим.

%20QUD7QS%2003.jpg)

Intel Itanium (2001)

Эти процессоры были попыткой получить очень высокий уровень производительности в параллельных вычислениях без увеличения частот. Так, они могли выполнять до 6 инструкций за такт (к примеру, современные Core i умеют всего 4), обладали кэшем в 24 МБ (против сотен килобайт у Pentium тех лет), 64-битную адресацию памяти (и это за 5 лет до выхода пользовательских 64-битных систем) и очень эффективное ядро, которое существенно повышало производительность CPU при работе с несколькими потоками задач.

Увы — как говорится, такие решения «не взлетели». Да, с одной стороны, в режиме IA-64 это был самый быстрый процессор для вычислений с плавающей запятой, но вот в целочисленных вычислениях он был на уровне обычных x86-процессоров с той же частотой. Более того — если x86-код не был оптимизирован под Itanium, то производительность могла упасть до 8 раз в сравнении с x86-CPU с такой же частотой! Также стоит отметить, что кэш третьего уровня (L3) имел хоть и огромный по тем временам объем, но все же по скорости он был несильно быстрее ОЗУ, что опять же тормозило процессор.

Ну и окончательно «добило» Itanic (шутливое название Itanium, созвучное с Титаником) то, что его выпустили спустя 3-4 года после задуманного срока (ибо Intel приходилось конкурировать с AMD с сегменте пользовательских CPU, и Itanium постоянно откладывали). В итоге выход в продажу совпал с коллапсом рынка доткомов, что повлекло за собой падение продаж серверов, а с учетом того, что на рынке тогда были такие мастодонты, как IBM с архитектурой POWER и Sun со SPARC — затея Intel провалилась.

Конечно, компания всеми силами пыталась спасти свое детище, и в итоге последние процессоры этой линейки вышли аж в 2017 году (правда, на 32 нм техпроцессе 5-летней давности), но, как мы знаем, заменить x86 они так и не смогли, и сейчас в высокопроизводительном сегменте царствуют Xeon.

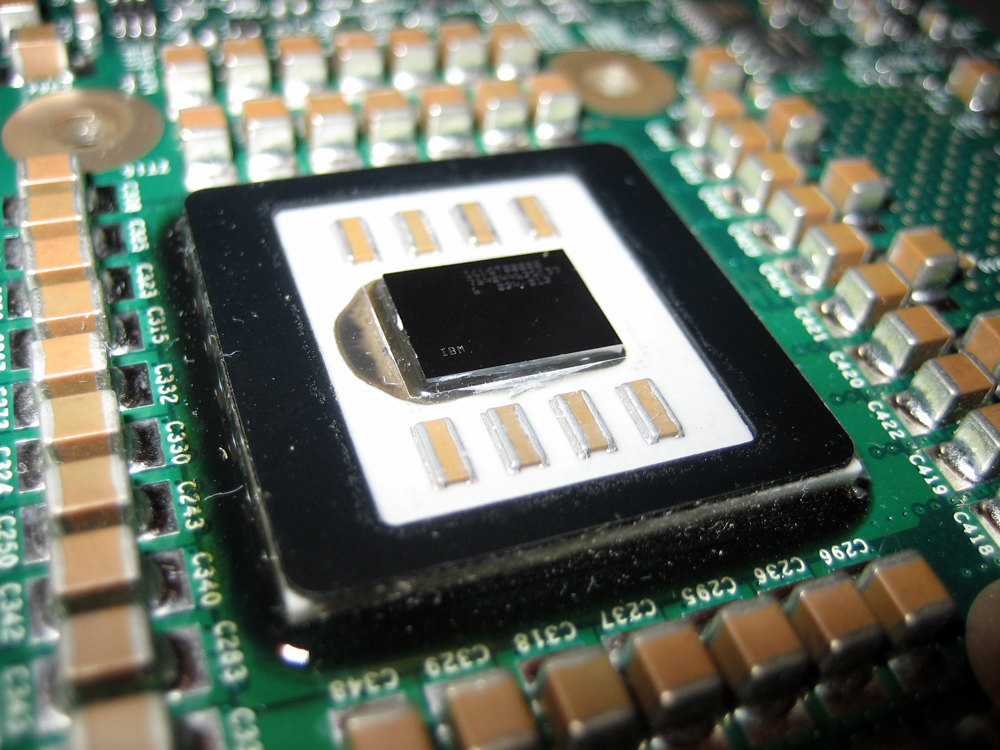

Intel Pentium 4 Willamette на Socket 423 (2000)

Слева — «нормальный» P4 для Socket 478, справа — «плохой» P4 для Socket 423.

В 2000 году Intel запускает линейку процессоров Pentium 4, а вместе с ней и новый сокет 423. И все бы хорошо, но вот только из-за конструкционных особенностей производство CPU с частотой выше 2 ГГц для такого сокета было просто невозможным, и в итоге в 2001 году компания переходит на достаточно известный и даже до сих пор используемый в ультра-бюджетных б/у ПК Socket 478, под который уже выходили Pentium 4 с частотой вплоть до 3.4 ГГц.

Конечно, пользователи были очень «рады» тому, что их новенький сокет устарел спустя полгода, и в итоге был даже сделан адаптер, позволяющий устанавливать процессоры для Socket 478 на 423, но вот сами Pentium 4 для этого сокета можно смело назвать неудачным вложением средств.

Cyrix 6x86 (1996)

Сейчас выпустить x86-совместимый процессор практически нереально — все патенты на них поделены между Intel, AMD и VIA. Но вот в 90-ые с этим было все проще, и на рынке существовала линейка процессоров Cyrix, которые можно было использовать в тех же сокетах, что и Intel Pentium, но при этом стоили такие решения все же дешевле.

Более того, «курики» в целочисленных вычислениях были существенно быстрее Pentium тех лет — к примеру, 133 МГц Cyrix мог на равных работать с 166 МГц Pentium, и тогда это имело смысл, ибо большая часть офисного софта использовала как раз целочисленные вычисления. Проектировщики Cyrix думали, что так будет и дальше, и прогадали — мир стал переходить на вычисления с плавающей точкой.

И тут низкая производительность FPU (математического сопроцессора) у 6x86 дала о себе знать — во-первых, инструкции выполнялись минимум за 4 такта, во-вторых, они не были конвейеризированы. В итоге с плавающей точкой Cyrix работали на уровне Intel 486, а с учетом популярности Pentium программисты напрямую стали работать с ассемблером для извлечения максимальной выгоды от конвейеризированного и работающего с малыми задержками FPU Pentium. В результате в том же Quake разница в производительности между Pentium и Cyrix была почти двукратная, и с учетом того, что такого софта с каждым годом стало становиться все больше — преимущество Cyrix достаточно быстро сошло на нет.

Cyrix MediaGX (1997)

Понимая, что «пора хватать чемоданы, вокзал отходит», компания стала метаться в попытках изобрести что-то новое, и итогом стала SoC MediaGX. Да-да, именно система-на-чипе — внутри было процессорное ядро 5x86, модули для работы с видео и аудио, контроллеры PCI и ОЗУ.

Идея была, конечно, хорошая, но вот компоненты были подобраны ужасно: так, 5x86 был конкурентом по целочисленным вычислениям лишь для Intel 486 (и это уже во времена Pentium II), не умел работать с кэшем L2 и имел совместимость с очень немногими платами, которые были рассчитаны именно под этот CPU.

В итоге эта SoC нашла применение лишь в нескольких компактных ноутбуках, где развернуть систему с полноценным CPU и графикой не представлялось возможным (а тут еще и видеопамять как таковая была не нужна — использовалась ОЗУ). Так что идея сделать SoC была отличная, и, как мы знаем, сейчас ее активно используют, но вот реализация была ужасной, что и погубило эту линейку чипов.

Texas Instruments TMS9900 (1976)

Qualcomm Snapdragon 810 (2014)

IBM PowerPC G5 (2005)

К середине нулевых было понятно, что Intel с их архитектурой x86 все же лучше, чем IBM с PowerPC. Когда появились первые процессоры G5, Apple надеялась, что в течение года IBM все же сможет преодолеть планку в 3 ГГц и тем самым выйти на один уровень с Intel, но, увы этого так и не произошло — вернее, такая частота достигалась, но для охлаждения приходилось использовать систему водяного охлаждения. В итоге Apple было нечем заменить G4 в своих ноутбуках, в результате чего было принято решение о переходе на Intel x86.

_1.1GHz_133MHz_Bus_Speed_Socket-370_512Kb_L2_Cache_Single_Core_Processor.jpg)

Pentium III 1.13 ГГц (2000)

Архитектура Pentium III была прекрасной для своего времени, и топовые решения на ней в первое время даже обходили Pentium 4 с куда большей частотой. Увы — Intel с AMD тогда участвовали в гонке «кто первый выпустит процессор с частотой выше 1 ГГц», и Intel решила закрыть глаза на то, что P3 на 180 нм с частотой в целых 1.13 ГГц работают нестабильно, и выпустила их в продажу.

Итог был немного предсказуем — пользователи, купив такой горячий, дорогой, да и еще к тому же нестабильный «камушек», требовали от Intel возврата средств, так что компании пришлось отозвать всю партию. В результате стабильные решения на 1.1 и 1.13 ГГц появились лишь годом позже, в ревизии D0.

Как видите, во все времена разные компании ошибались при создании CPU. В некоторых случаях это приводило лишь к небольшим проблемам, но зачастую это стоило им значительной доли рынка, а то и вообще ухода с него. И, разумеется, выше представлены далеко не все неудачные CPU, и в следующей части мы продолжим их список.

Наконец компания Intel решила создать новый процессор с нуля, в отличие от штамповки прежних поколений, когда она меняла только сокеты на материнских платах и названия поколений процессоров, используя с 2006 года одну и ту же архитектуру, лишь незначительно оптимизируя ее из поколения в поколение, и обходясь полумерами при устранении имеющихся «косяков». Создание нового процессора осуществилось по принципу: уверенный шаг вперед – это результат хорошего пинка в зад. И нетрудно догадаться, что этим пинком в зад оказались процессоры Ryzen компании AMD. Да, компания AMD в свое время пошла на очень большой риск, создавая с нуля процессоры Ryzen. По принципу, или все, или ничего, но им повезло, все получилось. Повезет ли теперь компании Intel, будут ли ее процессоры удачными и востребованными на рынке? Думаю нет, и для этого на мой взгляд, есть ряд причин, которыми хочу с вами поделиться.

реклама

Почему именно эту архитектуру выбрала Intel, нет ли в новой архитектуре очередного надувательства покупателей? Но обо всем по порядку.

Новые процессоры Intel Alder Lake построены по гибридной архитектуре, старшие модели которых будут содержать 16 ядер, разделенных на два кластера. Первый кластер будет содержать ядра Р-core (performance – производительные), а второй кластер E-core (efficiency – эффективные), причем производительные ядра будут двухпоточными, а энергоэффективные однопоточными. Процессоры будут поддерживать оперативную память DDR5 и шину PCIe 5. Презентация их состоится уже совсем скоро, 27 октября 2021 гола.

Техническое несовершенство процессоров Alder Lake.

Здесь у меня возникает первый вопрос, да простите меня дурака за такой глупый вопрос. А зачем вообще нужны для стационарного ПК процессоры с гибридной архитектурой? Для того чтобы при низкой нагрузке на процессор работали только энергоэффективные ядра и снижалось энергопотребление? Это серьезно? Сейчас вообще-то все процессоры умеют сбрасывать частоты при снижении нагрузки и уменьшать этим энергопотребление. Может процессоры Alder Lake на пару ватт при этом потребляют меньше, чем остальные? Ну да, для стационарного ПК пару ватт разницы, это очень существенно. Да, для ноутбуков, я не спорю, может Alder Lake и имеет место быть, в смысле в ноутбуках, где разница в несколько ватт потребления при одинаковой производительности будет иметь большое значение. Но зачем это в стационарных ПК? А я отвечу.

реклама

var firedYa28 = false; window.addEventListener('load', () => < if(navigator.userAgent.indexOf("Chrome-Lighthouse") < window.yaContextCb.push(()=>< Ya.Context.AdvManager.render(< renderTo: 'yandex_rtb_R-A-630193-28', blockId: 'R-A-630193-28' >) >) >, 3000); > > >);Маркетологи преподносят спорную гибридную архитектуру процессоров Alder Lake с технологией big.liTTLE, как революционное достижение, но на самом деле этим прикрывают несовершенство технологического процесса. Дело в том, что 10 нм. техпроцесс оказавшийся новым для Intel, в целом для индустрии уже пройденный этап, AMD уже давно использует 7 нм. Соответственно 10 нм. Intel заведомо прожорливее на ядро, чем 7 нм AMD. Обратите внимание, что по данным HWiNFO максимальная мощность потребления процессора Core i9-12900K в стресс-тесте составила 250 Вт.

Вот еще утекшие в сеть характеристики процессоров.

И эта мощность у Core i9-12900K на 8 производительных и 8 энергоэффективных ядер. Притом, что из-за 8 энергоэффективных ядер он не потребляет такую мощность, какую мог бы при всех производительных ядрах, еще большую. А у Ryzen 9 3950X потребление в пике только 200 Вт., и это на 16 производительных ядер. А теперь представьте, какое было бы потребление у Core i9-12900K при всех 16 производительных ядрах. Вот в чем и заключается надувательство покупателя. И надо отдать должное маркетологам компании Intel, как они профессионально преподнесли покупателю нерешенную проблему высокого энергопотребления под видом технического достижения. Ну и следует отметить, что производительность у Core i9-12900K все же неплохая, благодаря внедрению стандарта оперативной памяти DDR5, вышли так сказать из положения.

Windows еще не готова к работе с процессорами Alder Lake.

реклама

Для обеспечения максимальной производительности операционной системы Windows с процессором Alder Lake, планировщик потоков должен уметь правильно распределять задачи между энергоэффективными и производительными ядрами. По словам Криса Клейнханса, главного инженера-программиста Microsoft, в Windows 11 по умолчанию уже вшита технология «Intel Thread Director», обеспечивающая правильное распределение нагрузки между большими и малыми ядрами гибридных процессоров, а в Windows 10 она появится несколько позже в виде очередного обновления.

Но как показывает опыт, все новые «программные фичи», тем более касающиеся оптимизации работы новых, еще «сырых» процессоров, будут первое время, а может и довольно долгое время работать с «багами». К сожалению, это обычная, стандартная проблема всего нового.

Детские болезни первых процессоров новых архитектур

Процессоры Alder Lake, как было сказано в начале статьи, построены по новой архитектуре. А все первые процессоры новых архитектур, как правило, имеют детские болезни, и Alder Lake, я уверен, исключением не будет.

реклама

Вспомните, например, процессор Ryzen первого поколения «Zen», сколько у него было болезней, и капризный, недоработанный контроллер памяти, не дающий работать оперативной памяти на частоте выше 2666 Мгц. И недостаточный объем кэш-памяти L3, приводящий к низкой производительности процессора. Невысокая тактовая частота. Плохая однопоточная производительность. А исправили эти недочеты более-менее только в поколении «Zen2». Примерно то же самое будет происходить и с процессорами Alder Lake.

Высокая стоимость материнской платы под процессор Alder Lake

А если учесть, как часто Intel меняет свои сокеты, то берусь предположить, что 13 поколение процессоров Raptor Lake, в которых будут устранены некоторые проблемы Alder Lake, вполне может иметь другой сокет. И потому покупка «сырого» Alder Lake с новой, недешевой материнской платой теряет всякий смысл, ну или становится довольно рискованным решением. Кроме того понадобится новая система охлаждения, так как к процессору Alder Lake старая система охлаждения просто не подойдет.

Поэтому, в данной ситуации лично я бы не поменял процессор Ryzen (Zen 3) на Core i9-12900K.

Надеюсь, моя статья была для вас интересна.

Пишите в комментариях, приобретете ли вы себе какой-нибудь из процессоров Alder Lake после того, как они появятся в продаже.

Читайте также: